机器学习算法实践-线性回归

前面我们介绍了多种机器学习算法,但它们都是用来分类的,今天我们讲一下另一种类型,回归。回归是基于已有数据建立回归模型,对新的数据进行预测。今天要讲的是线性回归模型。

0线性回归模型主要学习内容

1)一元线性回归模型

2)多元线性回归模型

3)损失函数

4)正则化

1 一元线性回归

一元线性方程反映一个因变量与一个自变量之间的线性关系。即:

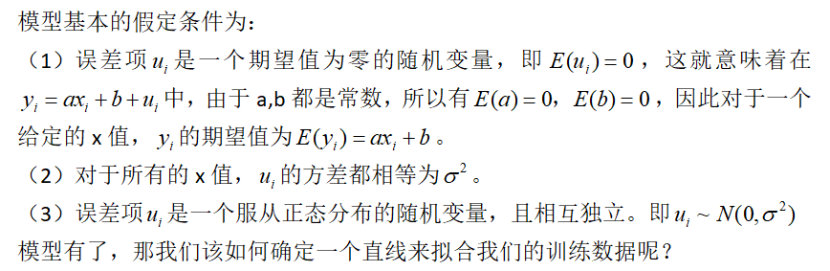

那一元线性回归模型呢?则为:

为了便于理解,下面举例说明:

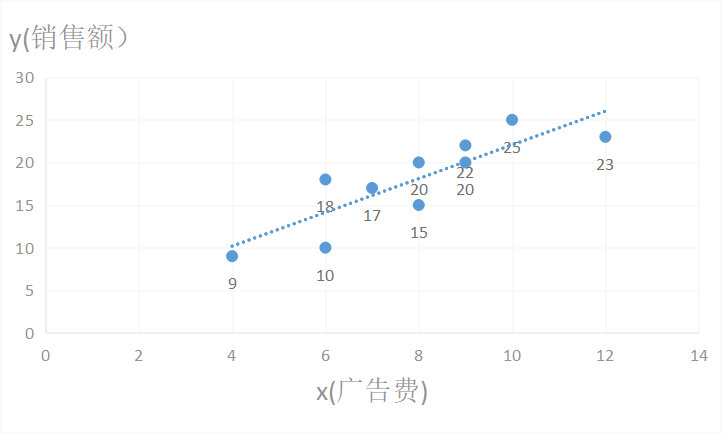

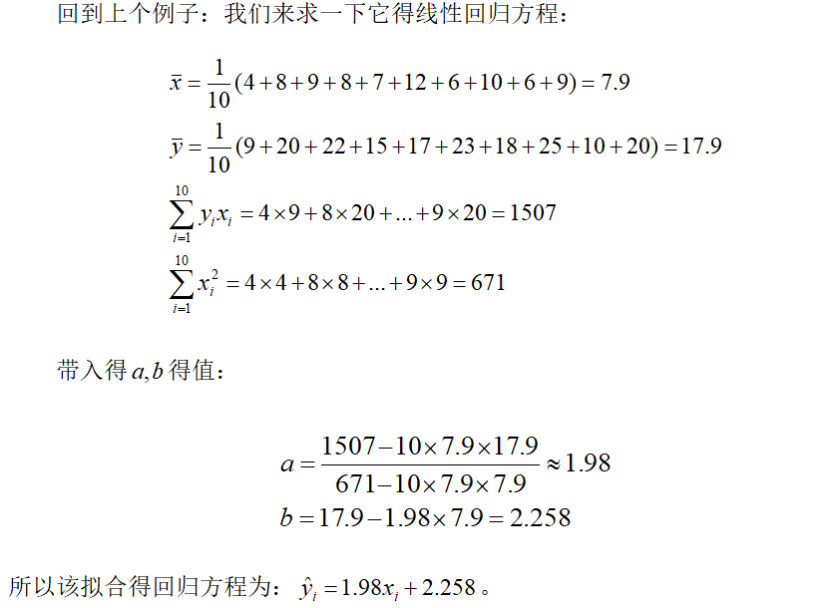

例:有一个公司,十个月的广告费用和销售额,如下表所示:

我们都知道广告费与销售额存在相关性,但具体是怎么的呢?

先将广告费和销售额画在二维坐标内,得到一个散点图,发现两者成直线上升的趋势,可利用一元线性回归来拟合这一条直线:

那具体怎么拟合的呢?如何确定拟合直线的效果好呢?

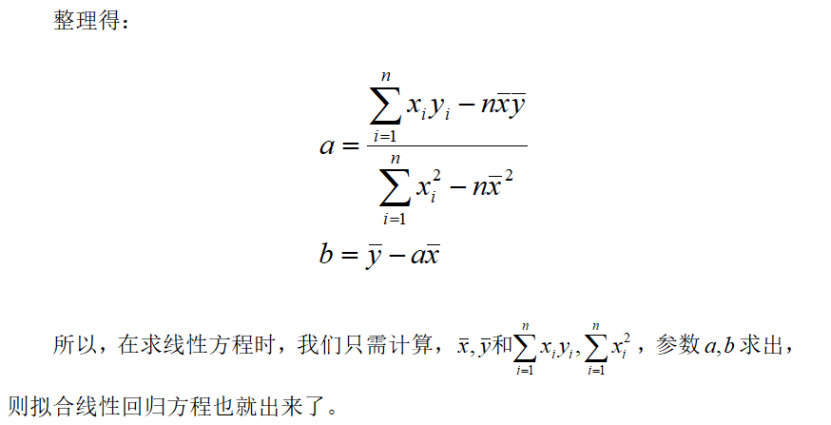

1.1线性回归的损失函数:平方误差

对于一元线性回归来说,可以看成Y的值随着X的值变化,每个实际的X都会有一个实际的Y值,,我们拟合一条直线,则每个实际的X都会有个直线预测Y值,我们要使每个真实的Y值与对应预测的Y值之差的平方和最小,即损失函数为:

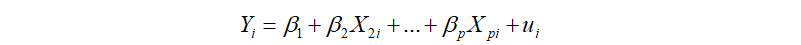

2多元线性回归

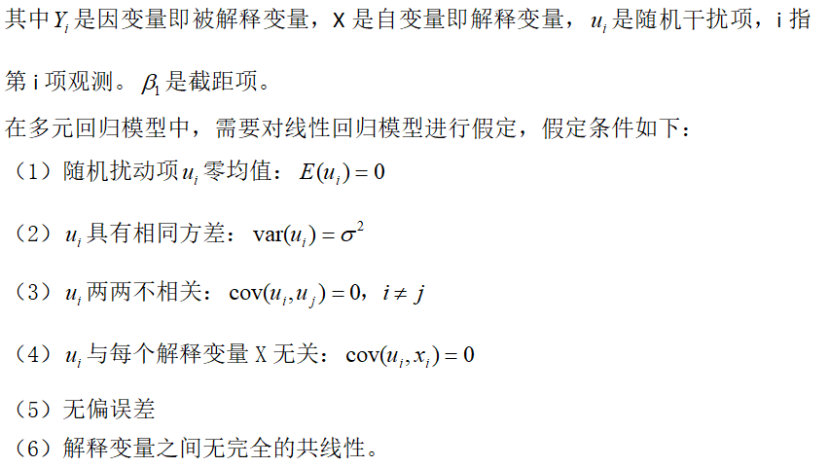

上一节讲的是一元线性回归,只要一个自变量x对因变量y作回归,那要是有两个或两个以上的自变量呢?这就是我们接下来要讲的多元线性回归,模型形式为:

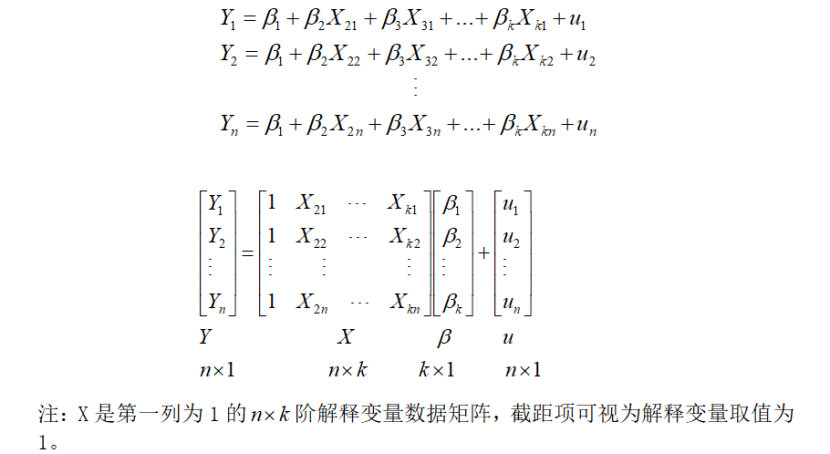

矩阵表示:

K-1个解释变量的多元线性回归模型的n次观测数据,可表示为

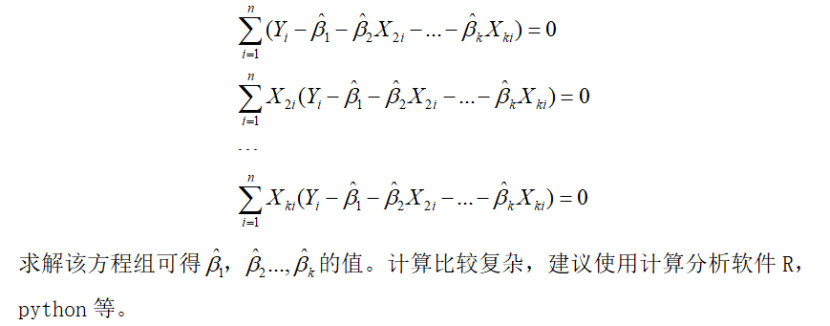

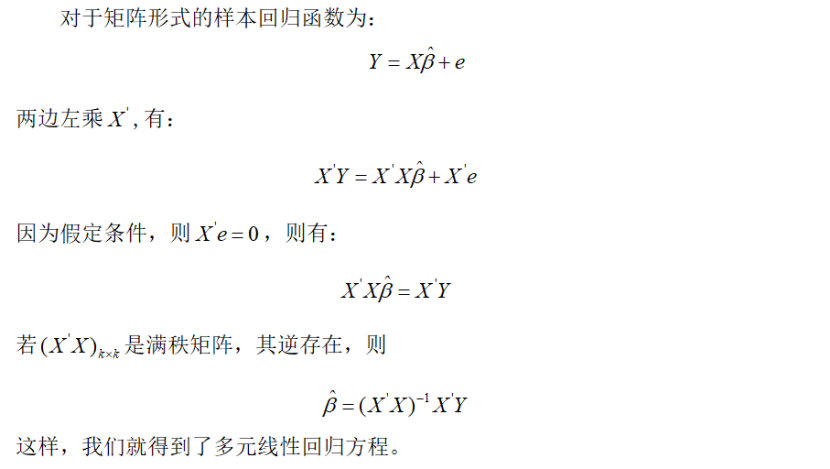

我们知道,对于多元线性回归中的最小化问题一般使用多元微积分求解,其原理与一元线性回归方程的最小二乘法相同,得到一个参数已求出的多元线性方程。

3 正则化

为防止模型的过拟合,我们在建立线性模型的时候经常需要加入正则化项,一般有L1正则化和L2正则化。

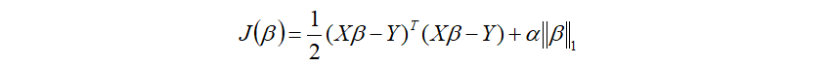

线性回归的L1正则化,通常称为Lasso回归:

Lasso回归可以使得一些特征的系数变小,甚至一些绝对值较小的系数值直接变为0。增强模型的泛化能力。

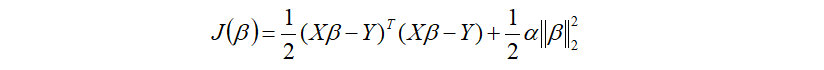

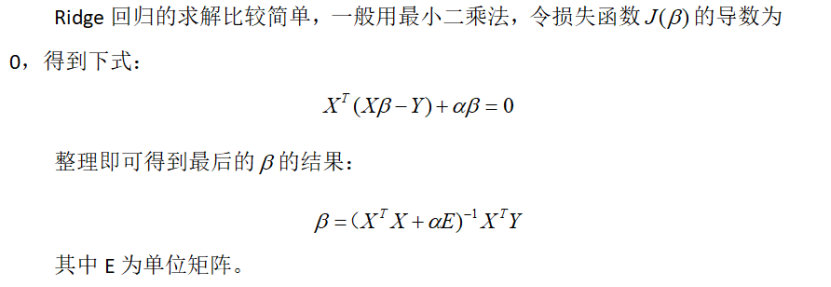

线性回归的L2正则化,通常称为Ridge回归:

Ridge回归在不抛弃任何一个特征的情况下,缩小了回归系数,使得模型相对而言比较的稳定,但和Lasso回归比,这会使得模型的特征留的特别多,模型解释性差。

4 线性回归总结

总的来说,线性回归模型就是用于分析变量之间的关系、以及变量是如何影响结果的一种方法。建立模型之后,可根据新变量预测其结果。

4.1 线性回归的优点

1. 建模速度快,不需要很复杂的计算,在数据量大的情况下依然运行速度很快。

2. 回归分析可以准确地计量各个因素之间的相关程度与回归拟合程度的高低,提高预测方程式的效果,可以根据系数给出每个变量的理解和解释。

4.2 线性回归缺点

1. 对异常值很敏感

2. 假定条件较多,并且选用何种因子和该因子采用何种表达式只是一种推测,这影响了因子的多样性和不可测性,使得回归分析受到限制。

5 线性回归的应用

1)广告费与销售额的关系

2)中国人口自然增长分析的应用

3)家庭用电预测

4)分析豆瓣评分与票房之间的关系

参考文献

[1] https://baike.so.com/doc/6956818-7179250.html

[2] https://blog.csdn.net/pql925/article/details/80084673

[3] https://www.cnblogs.com/pinard/p/6004041.html

[5] https://blog.csdn.net/Katherine_hsr/article/details/79942260

[6] https://blog.csdn.net/loveliuzz/article/details/78608897

(部分文字、图片来自网络,如涉及侵权,请及时与我们联系,我们会在第一时间删除或处理侵权内容。电话:4006770986 负责人:张明)

- 2026春节假期旅游舆情预案

- 政务舆情风险深度分析:信息录入与审核疏漏型事件

- 近期应急管理领域热点舆情汇总分析与春节前风险研判

- 春运保障视角下的春节网络舆情防范策略

- 2026年2月网络舆情风险预警分析报告

- 2026年旅游舆情报告:热点事件对地方文旅的影响分析

- 近期民生热点舆情分析研判报告

- 2025年12月网络热点舆情汇总分析报告

- 两节(元旦、春节)网络舆情风险预警报告

- 消费领域舆情分析报告:网络投诉热点梳理与舆情监测研判指南

- 2025年冬季季节性波动舆情预警分析报告

- 网络热点事件榜汇总分析(2025.12.1—12.15)

- 教育舆情主要集中领域及特征研判

- 2025年11月网络热点舆情汇总分析报告

- 2025 年 12 月网络舆情风险预警分析报告

- 舆情溢出效应:从个案危机到系统性质疑的传播机制研究

- 近期应急管理领域热点舆情汇总分析与研判报告

- 2025年10月网络热点舆情汇总分析报告

- 2025年11月网络舆情风险预警分析报告

- 舆情报告:近期社会热点舆情汇总分析

- 消费舆情:近期消费领域网络舆情深度分析报告

- 2025年供暖季网络舆情风险预警分析报告

- 教育舆情:近期教育领域网络舆情深度分析报告

- 2025年10月网络舆情风险预警分析报告(医疗类)

- 为什么随机刷到的视频的点赞数,首位数字三成是1? --谈本福特定律、社交网络推荐算法和对舆情工作这的启示

- 有效规范算法应用 营造清朗网络空间

- 社交网络内容分发算法对谣言类舆情传播的影响

- 机器学习算法实践-决策树

- 机器学习算法实践-随机森林

- 机器学习算法实践-感知机

- 机器学习算法实践-k近邻算法

- 机器学习算法实践-朴素贝叶斯算法

- 机器学习算法实践-神经网络

- 机器学习算法实践-Adaboost算法

- 机器学习算法实践-线性回归

- 机器学习算法-k均值聚类

- 深度学习-卷积神经网络

- 深度学习-循环神经网络RNN

- 自然场景文本识别